⭐Ek Bilgiler

⏬ Coursera Çalışma Dosyalarını İndirme

cd ~/work

tar cvfzh ~/workspace.tar.gz *

mv ~/workspace.tar.gz ~/work/workspace.tar.gz🎳 Dosyaların Boyutu 200MB'den Fazla İse

split -b 200m workspace.tar.gz workspace.tar.gz.part.Uygulamalar

Cloud Destekleri

Derin Öğrenme Notları

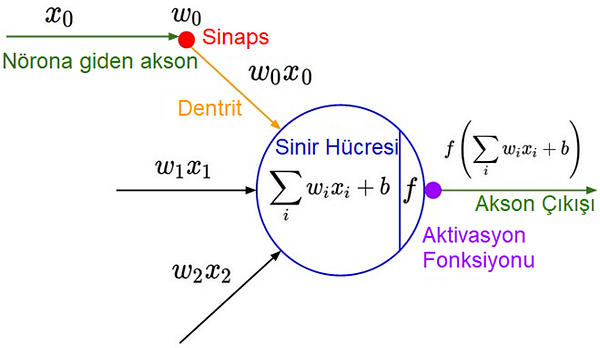

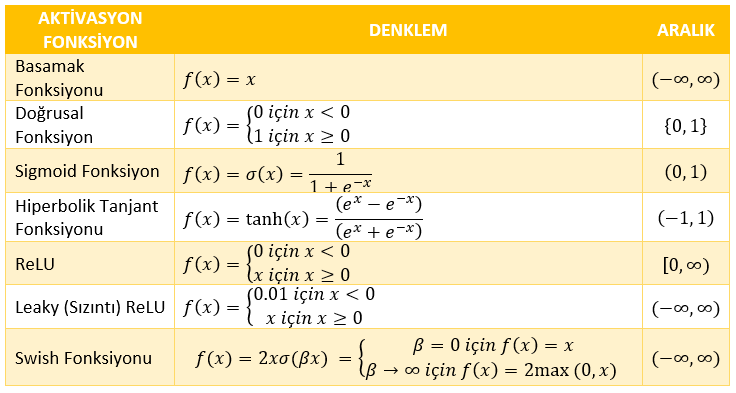

Aktivasyon Fonksiyonları

Aktivasyon Fonksiyonlarının Özellikleri

Yapay Zeka Kullanım Alanları

Harici Bağlantılar

Araştırmacılar Web Siteleri

GitHub Kaynakları

Firmalar

Karma

Derin Öğrenme Kaynakları

Motivasyon

Last updated

Was this helpful?